PHOTO

Il Disegno di Legge coglie elementi ed esigenze della regolazione dell’intelligenza artificiale, e predispone parte della normativa nazionale al recepimento del Regolamento europeo A.I. ACT.

Troviamo però inopportuno un disegno di legge con una delega così estesa al Governo.

Il ddl interviene regolando aspetti delicati di una tecnologia che, a detta di tutta la comunità scientifica, produrrà un cambiamento profondo dal punto di vista sociale, produttivo, lavorativo ed economico.

Negli ultimi mesi, a diversi livelli, la CGIL ha avviato discussioni, approfondimenti e audizioni presso le Commissioni X e XI della Camera dei deputati e partecipato a studi, lavori prodotti da gruppi di lavoro presso il CNEL, solo per parlare di realtà istituzionali.

Sarebbe stato quindi opportuno procedere attivando un dibattito largo e democratico nel Paese, soprattutto tra le parti sociali, istituzioni politiche, università, autorità indipendenti, enti di ricerca.

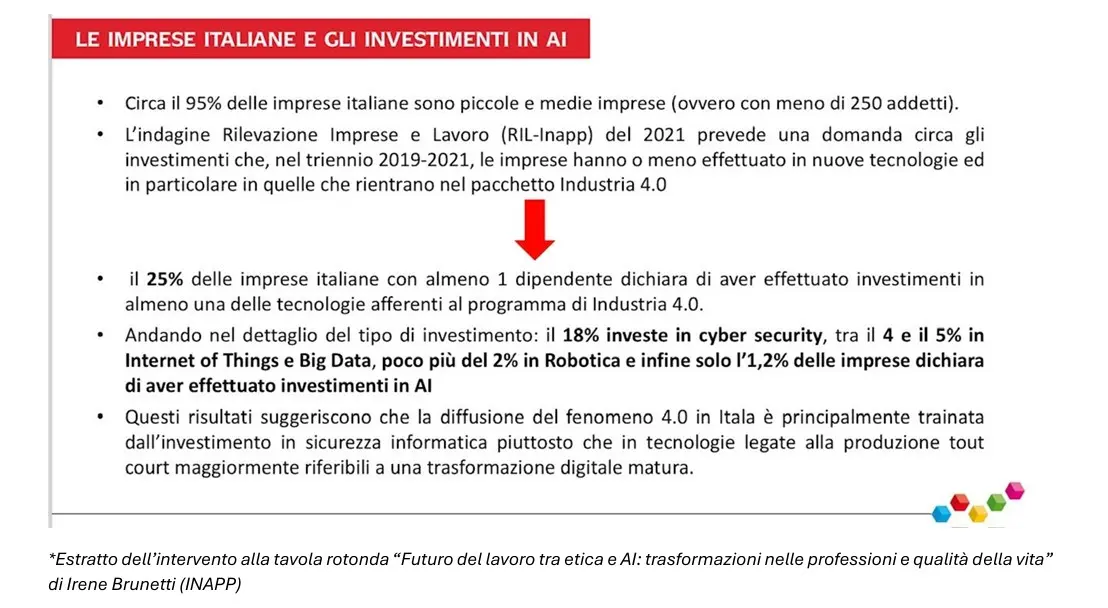

Rispetto alle politiche industriali e allo sviluppo dell’intelligenza artificiale, visto l’attuale quadro nazionale, comunitario e internazionale, ribadiamo l’esigenza più volte espressa di costruire politiche industriali pubbliche, o almeno, ad indirizzo pubblico per determinare una maggiore capacità di risposta agli evidenti squilibri globali nella “produzione” di intelligenza artificiale.

Continuiamo quindi a ritenere sbagliate le iniziative di privatizzazione e cessione a fondi esteri di grandi imprese pubbliche o ex pubbliche che, proprio in campo tecnologico, potrebbero essere soggetti predisposti a collaborare e creare start up con enti di ricerca ed università.

Apprezzabile, invece, il riferimento alla necessità di “mettere in rete” le buone pratiche.

A livello europeo, il modello da prendere a riferimento è sicuramente quello delle “fabbriche di intelligenza artificiale”, ecosistemi costruiti attorno ai super computer europei, che già in Europa si è deciso di mettere a disposizione di PMI e Sturt-Up.

Gli investimenti europei sono una prima risposta ad uno sbilanciamento globale nello sviluppo di nuove tecnologie e dell’intelligenza artificiale, ma i 4 mld di euro previsti per i prossimi anni, non sono sufficienti a rispondere allo squilibrio attuale ed al quadro di investimenti delle multinazionali USA o alla Cina.

È indispensabile avviare politiche industriali comunitarie, in un quadro di collaborazione tra Stati e imprese pubbliche e private. Il persistere della concorrenza tra grandi imprese europee rischia di lasciare il mercato inalterato nel suo sviluppo a trazione USA e Cina.

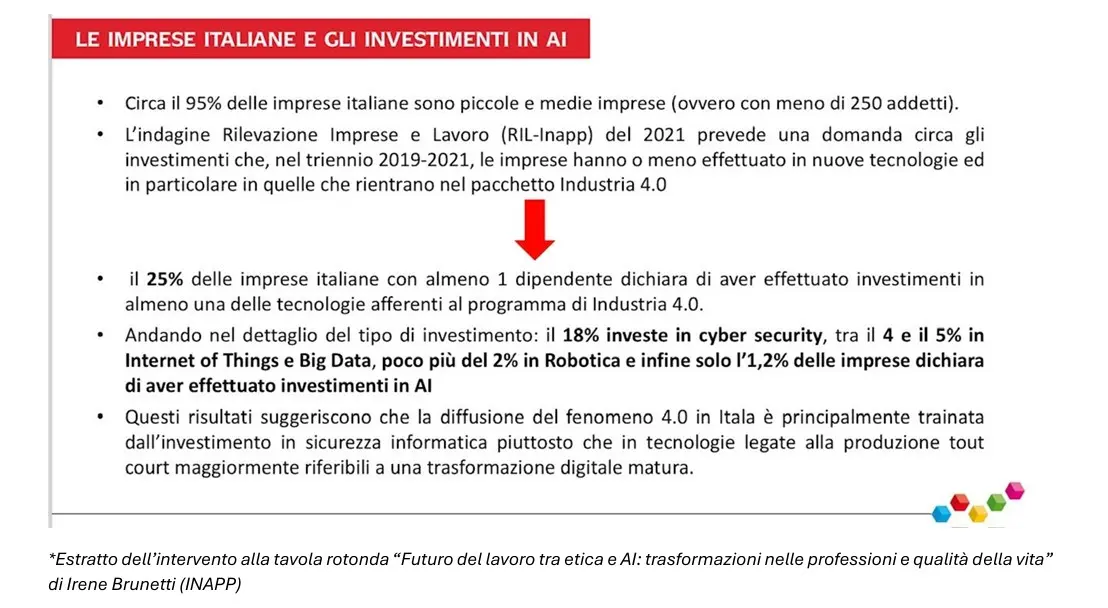

Non ci sembrano, a livello nazionale, sufficienti i fondi predisposti sia dal Governo che da CDP, oltretutto con una modalità che continua a premiare grandi imprese, spesso multinazionali non UE. L’esperienza di Industria 4.0, inoltre, evidenzia che il finanziamento generico, senza condizionalità, alle imprese private non determina effetti occupazionali rilevanti a fronte di ingenti risorse pubbliche investite.

Il modello di governance e di sviluppo dell’intelligenza artificiale predisposto tra Dipartimento della trasformazione digitale della Presidenza del Consiglio dei ministri, con approvazione del Comitato interministeriale per la transizione digitale e avvalendosi di agenzie come AgID (Agenzia per l’Italia digitale) e ANC (Agenzia Nazionale sulla Cybersicurezza) non ci sembra adeguato. Sulla questione torneremo parlando dell’istituzione dell’Autorità nazionale per l’intelligenza artificiale.

Ambito militare e sicurezza

Riteniamo che gli strumenti di intelligenza artificiale non dovrebbero essere utilizzati per il potenziamento o la realizzazione di armamenti offensivi.

I conflitti in corso ci segnalano vicende preoccupanti rispetto all’uso dell’intelligenza artificiale, con un aumento dell’efficacia nell’eliminazione del nemico e la grande mortalità della popolazione civile considerata, a tutti gli effetti, un effetto collaterale calcolato e accettabile.

Preoccupa, in tal senso, l’assenza di una regolamentazione internazionale e accordi che limitino questa deriva pericolosa e criminale.

Il monito arriva anche dal Garante per la protezione dei dati personali: “Si ritiene, non a torto, che le armi autonome possano rappresentare la nuova bomba atomica, per gli effetti dirompenti e l’assenza di regole che ne potranno caratterizzare l’utilizzo, tanto da qualificare quello attuale come un nuovo “momento Oppenheimer”.

Preoccupa anche che su tale materia, per lo sviluppo di tecnologie a scopo militare, si siano messi sullo stesso piano soggetti pubblici e privati, parlando di partenariato all’art. 16 m-quater.

Senza entrare troppo nella materia, siamo preoccupati per l’uso che strumenti di intelligenza artificiale, attraverso la raccolta di dati sensibili dei cittadini, potranno fare nel settore della sicurezza e della difesa nazionale.

La regolazione di queste materie definita da regolamenti interni, in “deroga” alla normativa ordinaria, per quanto attiene i dati sensibili, combinato con una eccessiva “larghezza” del Regolamento UE in materia, rischiano di dare, proprio perché parliamo di strumenti ad altissima intrusività nella vita delle persone, una scarsa trasparenza alle iniziative delle autorità di polizia e militari.

Su tale questione, non ci sembra sufficiente quanto definito dal Regolamento europeo in ordine ai limiti posti dall’autorità giudiziaria e nella definizione di reati gravi, termine quest’ultimo con un’ampia interpretabilità dai singoli Stati facenti parte dell’Unione.

Come afferma anche il Garante, “…l’Ai Act, nel delineare il sistema di governance dell’I.A., sancisce una specifica riserva di competenza a favore delle Autorità di protezione dei dati, in particolare in settori (immigrazione, attività di contrasto, giustizia, processi democratici) nei quali la potenza algoritmica rischia di amplificare la strutturale asimmetria del rapporto in cui si iscrive o le vulnerabilità proprie, per condizioni soggettive o circostanza, degli interessi”.

Ambito sanitario

Certamente l’uso in ambito sanitario è elemento positivo per la cura dei malati, l’assistenza sanitaria, l’assistenza domiciliare, l’analisi delle dinamiche delle patologie, come il miglioramento della capacità di ricerca.

Presupposto perché non vi siano abusi ed eccessi è la necessità di una corretta informazione dei cittadini, trasparenza nell’uso dei dati e mai, come viene detto anche nel testo del ddl, l’uso di IA dovrà limitare l’accesso alle cure di nessuno.

Per questo non ci convince l’accesso dei privati, alla pari con soggetti pubblici, nella raccolta e uso dei dati sensibili dei cittadini anche se “senza scopo di lucro” in ambito di ricerca e sviluppo.

In questo settore è assolutamente necessario che la ricerca e la sperimentazione nella realizzazione di sistemi di intelligenza artificiale siano predisposti dal pubblico, perché anche un accesso secondario ai dati di soggetti privati, per quanto si ipotizzi anonimizzato, rischia di generare investimenti sulla base di scelte di carattere commerciale e con finalità di lucro e non nell’interesse generale e della collettività.

Nell’articolo 8 mancano le indicazioni esplicite sull’uso dei dati dell’AI che non produca discriminazioni di genere in fase di ricerca e sperimentazione scientifica. Si pensi ad esempio ai limiti dimostrati fino ad oggi nella selezione e nell’utilizzo dei dati ai fini della ricerca in ambito sanitario, come dimostrato ampiamente nella medicina di genere.

Si ritiene riduttivo affidare ad AGENAS (Agenzia Nazionale per i Servizi Sanitari Regionali) la sola realizzazione di una "piattaforma" non ben definita, e riservata a specifiche categorie di professionisti sanitari. La normativa non spiega perché alcuni professionisti siano esclusi e perché l'AGENAS non sia menzionata nell'FSE (Fascicolo Sanitario Elettronico), sollevando dubbi sulla strategia delineata.

Non viene chiarita la relazione tra la piattaforma, AGENAS e il FSE.

Mancano regole chiare per l'uso della tecnologia sanitaria, inclusi vincoli per i soggetti privati a scopo di lucro, dato il loro probabile coinvolgimento nei sistemi di intelligenza artificiale, compito non affidato ad AGENAS.

Ambito lavoro

Come abbiamo già evidenziato in diverse occasioni, gli strumenti di intelligenza artificiale possono intervenire positivamente nell’attività lavorativa, in alcuni casi riducendo i rischi o l’impegno fisico e mentale in alcuni processi ripetitivi o faticosi. È però essenziale che tali strumenti, qualora siano compatibili con le previsioni normative, siano introdotti a seguito di un percorso di confronto tra le parti, oltre ad una adeguata e trasparente informativa ai lavoratori interessati.

Le nozioni indicate al comma 1 (miglioramento condizioni di lavoro, aumento della produttività) hanno un carattere di estrema genericità, elemento che confligge con l’intenzione di identificare specifiche finalità per le quali possa essere giustificato l’uso di IA nei contesti lavorativi.

Altrettanto generiche le garanzie richiamate al comma 2 (affidabilità, trasparenza, sicurezza) per la definizione delle quali si rinvia ad altre norme nuove, come il regolamento europeo IA, e meno recenti, come l’art. 1-bis del D.lgs. 152/1997, che tra loro divergono anche nella declinazione delle tecnologie stesse a cui si riferiscono: intelligenza artificiale in un caso e sistemi decisionali e di monitoraggio integralmente automatizzati nell’altro.

Utile ma non esaustiva la previsione dell’obbligo di informativa, in un quadro generale e teorico di diritti e principi.

Nel testo, manca al comma 2 art. 10, il riferimento all’informativa/confronto con le organizzazioni sindacali o i rappresentanti dei lavoratori (comma 6, art 1bis del decreto legislativo 26 maggio, 1997, n. 152), elemento centrale per la tutela collettiva delle lavoratrici e dei lavoratori.

Il comma 3), così formulato, sembra attribuire all’intelligenza artificiale “l’organizzazione e la gestione del rapporto di lavoro”. Andrebbe, invece, proprio nel rispetto dei diritti inviolabili richiamati, chiarita la centralità della supervisione di natura umana.

Infine, manca nell’elencazione dei diritti inviolabili, la “libertà di adesione ad una organizzazione sindacale”, senza che questo determini una discriminazione. Lo reputiamo indispensabile, perché in diversi pronunciamenti (Bologna, Palermo, Torino) il giudice ha individuato, da parte di sistemi algoritmici e di intelligenza artificiale che “organizzavano” l’attività di consegna dei rider, comportamenti discriminatori nei confronti di lavoratori che avevano aderito a scioperi indetti dalle organizzazioni sindacali.

Troviamo positiva l’istituzione di un osservatorio sull’adozione di sistemi di intelligenza artificiale nel mondo del lavoro, riteniamo però necessaria la creazione anche di un tavolo di confronto. Indispensabile, infatti, visto il profondo processo avere un tavolo istituzionale nel quale ragionare di contrattazione, durata della prestazione lavorativa, formazione, politiche attive, professioni, processi produttivi, politiche industriali.

Si prevede poi per l’introduzione dell’I.A. nella PA una invarianza di risorse finanziarie, umane e strumentali disponibili a legislazione vigente. È per noi impossibile pensare ad un processo di innovazione fondamentale per la pubblica amministrazione, indispensabile per il generale sviluppo del Paese, senza un incremento di risorse economiche, di organico e formazione.

Non ci è chiaro quale sarà l’integrazione tra questa previsione e le risorse del PNRR a disposizione.

Disposizioni in materia di professioni intellettuali

Assume rilevanza l’introduzione di un articolo dedicato specificatamente alle attività intellettuali e il fatto che il legislatore utilizzi anche qui un principio antropocentrico, per cui resta centrale il lavoro umano e l’IA potrà essere usata solo in funzione di supporto (a titolo esemplificativo, si può pensare ad attività di ricerca giurisprudenziale avanzata, calcoli e impostazioni di file Excel, lettura veloce di documentazione ponderosa, ecc.).

Tuttavia, l’articolo, che rientra nelle disposizioni in materia di lavoro, guarda alle attività del professionista solamente in ottica di prestazione resa verso il cliente e non anche al professionista in quanto lavoratore (professionista/cliente vs. professionista/committente).

In altri termini, focalizza l’attenzione sulla responsabilità della scelta operativa dell’uso degli strumenti di IA, che ricadrà sempre sul professionista intellettuale, e non sull’impatto che l’uso di strumenti di IA potrà avere sulle opportunità lavorative (verosimilmente si potrà verificare una diminuzione del lavoro di professionisti e collaboratori), sulla qualità della domanda (anche qui l’utilizzo di strumenti di IA, potrebbe far calare la proposta del committente rispetto al compenso per il professionista) e sulla qualità del prodotto (l’uso di strumenti di intelligenza artificiale, velocizzando alcune attività, potrebbe far ridurre i tempi del contratto di prestazione).

Anche il secondo comma, deontologicamente corretto per una norma di trasparenza, affronta il tema nell’ambito del solo rapporto professionista cliente, imponendo l’informativa al cliente sull’impiego dello strumento. Anche qui, nella sua essenzialità e concisione, la norma resta vaga: i clienti devono sapere se si rivolgono a un professionista che ricorre all'intelligenza artificiale, ma non è chiaro chi si occuperà del monitoraggio del rispetto di questa norma.

Andrà comunque valutata una – rapida – integrazione delle informative rese ai sensi dell’articolo 14 del GDPR ai clienti, con riferimento all’impiego di IA con l’indicazione del tipo di metodo di conservazione (cloud, server dedicato) e, forse, anche dei sistemi di cybersecurity adottati per tutelare i dati.

Va meglio chiarito, a tutela del lavoro e delle professioni intellettuali, con quali modalità “le informazioni relative ai sistemi di intelligenza artificiale utilizzati dal professionista sono comunicate al soggetto destinatario della prestazione intellettuale con linguaggio chiaro, semplice ed esaustivo”.

Si segnala a tal proposito che esistono già in rete programmi che, utilizzando l’intelligenza artificiale, sono in grado di superare i rilevatori di AI e dunque di rendere i testi prodotti da questa tecnologia indistinguibili da quelli umani. La semplice comunicazione, temiamo, non sia dunque sufficiente.

Andrebbe piuttosto spinta l’introduzione del watermarking, ovvero di un sistema digitale che serve a proteggere e autenticare i contenuti digitali.

Strategia nazionale e Autorità nazionali per l’intelligenza artificiale

Riteniamo che, attraverso l’attribuzione all’Agenzia Nazionale sulla Cybersicurezza (ANC) e Agenzia per l’Italia digitale (AgID), si continuino a confondere i piani della “governance dell’intelligenza artificiale”.

Andrebbe slegata l’iniziativa politica del Governo per lo sviluppo industriale ed economico dell’I.A. dalla funzione di controllo e verifica amministrativa in ottemperanza dell’attuazione del regolamento di cui al comma 1, di un’autorità di vigilanza del mercato, di notifica, nonché di contatto con le istituzioni dell’Unione europea.

Se infatti è giusto che le politiche siano in capo alla Presidenza del Consiglio ed i Ministeri che si occupano di innovazione tecnologica, CITD (Comitato Interministeriale Transizione Digitale), diversa e caratterizzata da una terzietà e indipendenza dovrebbe essere l’azione di controllo e verifica nella produzione e utilizzazione dell’intelligenza artificiale.

Tema rilanciato da ultimo dal Presidente de il Garante per la protezione dei dati personali, Pasquale Stanziale, con la sua relazione per l’anno 2023, tenutasi il 3 luglio 2024 presso la Camera dei deputati. Ragionamento con cui Stanziale ha ribadito il ruolo fondamentale del Garante nella regolazione dell’intelligenza artificiale legata inscindibilmente al trattamento dei dati.

Come CGIL lo abbiamo già detto anche in audizioni pubbliche in X e XI commissione della Camera dei deputati negli scorsi mesi: se vogliamo costruire un modello che utilizzi in maniera sana la trasformazione generata

dall’intelligenza artificiale e più in generale il processo di digitalizzazione, è indispensabile definire spazi di “confronto distinti”. Il primo sulle politiche industriali, tra parti sociali e istituzioni. Il secondo tra autority e organizzazioni sindacali. Per fare questo è necessario partire dal rafforzamento del Garante per la protezione dei dati personali, AGCOM, AGCM, Consob, dando loro risorse, autonomia finanziaria, personale e strumenti tecnologi e infrastrutturali adeguati a controllare e contrastare abusi e illeciti in un raccordo operativo con le organizzazioni sindacali.

Le due Agenzie, individuate dall’art. 18, non sono “autorità amministrative terze”, così come richiesto dalla regolamentazione europea, ma sono emanazione della Presidenza del Consiglio e interamente dipendenti dal

Governo.

Inoltre, non hanno le caratteristiche funzionali e tecniche per rispondere ai compiti identificati nella delega.

È invece necessario, come è stato per l’attuazione del GDPR, identificare una autorità che abbia specifiche capacità tecniche e giuridiche e autonomia funzionale.

Tra le altre cose, alle stesse agenzie, viene attribuito di agire anche sui settori di pertinenza dal punto di vista dello sviluppo industriale dell’IA in raccordo con il “Governo”.

Vogliamo a tal proposito ricordare la cancellazione dell’Istituto per la Cybersicurezza nella scrittura del PNRR, condizione che oggi ci vede in ritardo di due anni rispetto al resto d’Europa nella definizione di un Istituto che avrebbe dovuto indirizzare e sostenere la ricerca e supportare economicamente progetti pubblici e privati.

A nostro avviso è necessario definire una Autorità per l’intelligenza artificiale, come definito nel regolamento europeo, ripercorrendo quanto si fece con il Garante per il trattamento dei dati, forse, per facilitare l’attuazione del Regolamento, anche guardando ad una collaborazione tra diverse autorità già esistenti e che oggi già svolgono attività riconducibili alla fattispecie.

Vogliamo ricordare che proprio l’ultima Direttiva Europea sui lavoratori delle piattaforme digitali indica la necessità e chiede agli Stati dell’Unione di rafforzare le autorità indipendenti, per una puntuale regolazione del mondo del lavoro, per ovviare ad azioni irregolari delle imprese che utilizzano sistemi algoritmici e di intelligenza artificiale, dinamica che la stessa UE prevede in crescita.

Invece da una parte la delega male attribuisce le competenze sulla regolazione dell’I.A., dall’altra il Governo non rafforza le autorità indipendenti, in difficoltà dal punto di vista economico e organizzativo, con un organico molto qualificato, ma assolutamente insufficiente a rispondere alla diffusione del fenomeno, oltre ad una struttura funzionalmente sottostimata ed una progressiva riduzione dell’autonomia decisionale delle strutture che istruiscono casi e procedono alle ispezioni.

Questo però sembra ormai essere una scelta, sono anni che si lascia l’Ispettorato Nazionale del Lavoro agonizzare con scarse risorse e ormai una conclamata incapacità di intervenire efficacemente sulle realtà territoriali.

Deleghe al Governo

I perimetri di delega alla decretazione attuativa sono ampi (art. 22):

Comma 1

• Designazione dell’autorità prevista all’art. 18.

Comma 2

• Percorsi di alfabetizzazione e formazione.

• Previsione, da parte degli ordini professionali, di percorsi di alfabetizzazione per professionisti e gli operatori del settore; previsione di un riconoscimento di un equo compenso in relazione all’attività.

• Potenziamento, all’interno dei curriculum scolastici, dello sviluppo di competenze scientifiche STEM.

• Previsione, nei corsi universitari e della formazione artistica AFAM e Istituti tecnologici superiori (ITS Academy), attività formative anche con riferimento ai sistemi di intelligenza artificiale.

• Valorizzare le attività di ricerca e trasferimento tecnologico in materia di intelligenza artificiale svolto da Università, AFAM, ITS Academy.

Sull’azione diretta a sostenere la formazione professionale e la formazione nell’uso consapevole dell’intelligenza artificiale verificheremo quali processi vorrà definire MIUR ed MUR, ribadendo sempre l’esigenza di un confronto con le parti sociali in un processo di trasformazione profondo per studenti, insegnanti, docenti e ricercatori.

Invece troviamo insoddisfacente quanto ipotizzato per il sostegno alla formazione delle lavoratrici e lavoratori, sia dipendenti che autonomi.

Nel primo caso rileviamo sarebbe essenziale un sostegno concreto ai fondi interprofessionali, con risorse pubbliche indirizzate ai processi di formazione sulle nuove tecnologie, senza che questo debba presupporre l’uso di ammortizzatori sociali o la rimodulazione delle attività in una fase di contrazione.

Al comma 2 lettera c) del presente articolo il legislatore introduce due previsioni su cui porre l’attenzione:

- percorsi di alfabetizzazione e formazione per i professionisti e operatori nei propri specifici settori, sull’uso degli strumenti di IA;

- il riconoscimento di un equo compenso che sia “modulabile” sulla base delle responsabilità e dei rischi connessi all’utilizzo degli strumenti di IA.

Entrambe le previsioni sono vaghe e lasciano ampia interpretabilità nell’applicazione. Manca un riferimento stringente alla loro applicazione e alcuni elementi di dettaglio: chi dovrà prevedere i percorsi di alfabetizzazione e formazione per i professionisti e operatori? E a carico di chi saranno?

Nella relazione tecnica di accompagnamento al ddl si fa esplicito riferimento non solo al fatto che la previsione di tali corsi non determina effetti negativi sulla finanza pubblica, ma si aggiunge che tale formazione specifica e aggiornamento “dovrà essere a carico del libero professionista che intende avvalersene nell’esercizio del suo lavoro” (art.12 - p.22) e che dovrà essere equamente compensata nei corrispettivi spettanti al professionista incaricato e poste a carico dell’utente finale. Dunque, in questa previsione ne deriva un aggravio per il cliente (dapprima tutelato) e allo stesso tempo una superficiale valutazione del lavoro del professionista, alla cui sola responsabilità viene demandata la scelta dell’utilizzo degli strumenti di IA, senza considerare la posizione di debolezza nei confronti di alcune tipologie di committente.

Secondo elemento: chi decide e come viene calcolato un compenso “equo e modulabile sulla base delle responsabilità e dei rischi”?

Anche qui la norma resta vaga e non richiama neanche la L. 49/2023 sull’equo compenso, che prevede l’individuazione di parametri per la determinazione dello stesso da parte del Mimit per le professioni intellettuali non ordinistiche, e per i quali è ancora in corso il confronto con 11 aggregazioni di associazioni.

Come vengono, inoltre, determinati i rischi?

Un’ultima considerazione, non meno importante, rileva rispetto alla platea delle professioni intellettuali considerate in entrambi gli articoli, che fanno riferimento esclusivo a quelle rientranti in ordini e collegi, lasciando fuori milioni di professionisti non regolamentati, ancora una volta delineando una visione parziale del legislatore e del governo rispetto al mercato del lavoro di riferimento.

Questi temi dovrebbero far parte di una più generale strategia di accompagnamento alla transizione digitale da affrontarsi in tavoli istituzionali e di settore tra le parti, per una pianificazione puntuale dei processi di trasformazione professionale e piani formativi idonei alla crescita di competenze necessarie ad accompagnare lo sviluppo.

Comma 3/4/5

Entro dodici mesi dalla entrata in vigore della legge si dovranno adottare decreti legislativi attuativi per disciplinare organicamente la disciplina per l’uso di sistemi di intelligenza artificiale in maniera illecita.

L’impianto giuridico sul quale non entriamo nello specifico, prevede sanzioni pesanti, ma che essenzialmente intervengono sulle così dette deep fake o nei confronti di reati contro le “istituzioni”, tralasciando di fatto un perimetro molto più esteso di effetti che l’uso difforme di queste tecnologie possono comportare al singolo cittadino, al minore, al lavoratore e più complessivamente alla collettività, soprattutto per il rapporto asimmetrico di potere tra questi e le multinazionali produttrici o le imprese che ne fanno uso in maniera illecita.

Tutela del diritto d’autore (art. 23)

Sul tema il decreto legislativo realizza un generico “aggiornamento delle norme” che definiscono il diritto d’autore (Legge 633/1941 e la direttiva europea 2019/790) ricomprendendo l’I.A., ma le previsioni del ddl rimangono insufficienti per una piena tutela di questa materia.

Abbiamo, con le nostre categorie, a lungo sostenuto che gli autori devono avere il controllo sui loro lavori e che venga loro riconosciuto il giusto compenso per la creazione e l’uso delle loro opere. Il ddl S 1146 impegna a rafforzare questi diritti, provando teoricamente a garantire il diritto di Riproduzione e Distribuzione: autori e creatori hanno il diritto esclusivo di autorizzare la riproduzione e la distribuzione delle loro opere.

Il ruolo delle parti sociali e della contrattazione non sono sufficientemente identificate. Sarebbe per noi opportuno dare consistenza al Comitato consultivo permanente per il dda, nonché della SIAE, che, vista la difficoltà di misurare il valore generato dallo sfruttamento, tramite IA, di ogni singola opera, andrebbe valorizzata come possibili modalità di remunerazione collettiva degli autori secondo il modello del prestito pubblico e della reprografia, con contribuzione a carico delle imprese sviluppatrici e dei committenti.

La stessa modalità potrebbe essere utilizzata per sostenere i percorsi di formazione delle lavoratrici e dei lavoratori.

Serve dunque identificare un tavolo di confronto istituzionale permanente sul tema, con la partecipazione delle parti sociali rappresentative del settore, per identificare le modalità di regolazione, verificare il rispetto del diritto d’autore e identificare le politiche di sostegno al settore.

Infine, ribadiamo l’esigenza di un rafforzamento delle autorità indipendenti, in questo caso per le funzioni assegnate dall’attuale normativa al Garante per la protezione dei dati personali e all’AGCOM a cui, negli anni, sono state attribuite sempre maggiori funzioni nel settore creativo, delle telecomunicazioni e del digitale, incluso il giudizio sull’equità dei compensi.

Tutele e diritti

Sempre nella relazione del Presidente del Garante per la protezione dei dati personali c’è un richiamo all’esigenza di rafforzare l’azione di contrasto ai reati digitali, Revenge porn, deep fake spesso anche di minori.

Stessa indicazione arriva dal CNEL, “…sarebbe auspicabile se venissero aggiunti riferimenti alla manipolazione di immagini di donne e minori e alla violenza di genere. Il CNEL ritiene possa invece essere una buona occasione per sanzionare tali comportamenti in accordo con la Direttiva (UE) 2024/1385 del Parlamento europeo e del Consiglio - sulla lotta alla violenza contro le donne e alla violenza domestica”.

Infatti, mentre nel testo del Disegno di legge è evidente un’attenzione al tema delle “disabilità”, è assente la prospettiva di genere e quindi qualunque strumento di contrasto e sanzione avverso gli effetti potenzialmente discriminatori dell’Intelligenza artificiale sulla vita e il lavoro di donne e lavoratrici. In una società quale quella italiana, già fortemente caratterizzata da discriminazioni e gap di genere, come evidenziano tutte le statistiche europee e nazionali, e da una cultura discriminante, l’assenza di una ottica di genere rende la legge sull’intelligenza artificiale altamente rischiosa per le donne e le lavoratrici.

Nel disegno di legge, questi rischi, non trovano strumenti di contrasto e sanzione: gli unici passaggi che disciplinano in maniera generica il rischio di discriminazioni di genere sono quelli dell’art 3 c. 1 (principi generali) e dell’art.10 (lavoro).

Si rileva pertanto l’esigenza di introdurre all’interno della legge strumenti a tutela delle pari opportunità che contrastino le discriminazioni che colpiscono le donne - che sono, ricordiamo, non una minoranza ma il 50% della popolazione -, come meccanismi di prevenzione, controllo, e ricorso avverso gli effetti di una IA discriminante.

Allo stesso modo bisogna identificare e rafforzare la tutela dei minori, sempre più a rischio per l’elevata esposizione derivante dall’uso sempre più precoce di strumenti digitali, sia attraverso un’alfabetizzazione al digitale, che nella previsione di reati e pene.

La stessa scuola, a partire dalle medie, invece di essere concentrata sul divieto dell’uso dei telefoni in classe, dovrebbe predisporre gli studenti ad un utilizzo consapevole degli strumenti digitali. Dovrebbe preparare i minori ad una maggiore conoscenza dei rischi e ad un utilizzo corretto e critico.